Engenharia de Prompts de Alta Eficiência. Maximizando o Potencial dos Modelos de Linguagem Grandes (LLM).

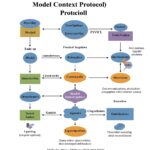

A engenharia de prompts emergiu como uma disciplina crucial para extrair o máximo desempenho de Modelos de Linguagem Grandes (LLMs). Trata-se do processo iterativo de projetar e refinar as instruções fornecidas a um LLM para obter resultados precisos, relevantes e que atendam ou superem as expectativas do usuário.1 Este relatório consolida as melhores práticas e técnicas avançadas, extraídas de documentações oficiais dos principais LLMs (OpenAI, Claude, Gemini, Qwen) e de pesquisas especializadas, oferecendo um guia passo a passo para a criação de prompts otimizados.

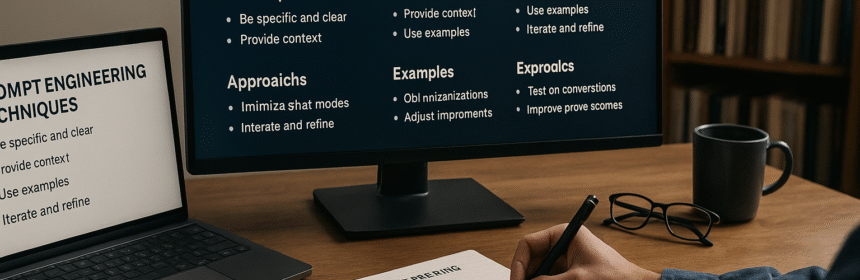

I. Pilares Fundamentais da Engenharia de Prompts Eficaz

Antes de mergulhar em técnicas avançadas, é imperativo dominar os princípios básicos que sustentam a criação de prompts eficazes. Estes fundamentos são universalmente aplicáveis e formam a base para interações bem-sucedidas com qualquer LLM.

A. Clareza, Especificidade e Detalhamento da Instrução

A pedra angular de um prompt eficaz é a clareza inequívoca da instrução. Os LLMs, apesar de suas capacidades avançadas, não conseguem ler mentes.1 Portanto, é essencial fornecer instruções explícitas, detalhadas e desprovidas de ambiguidades. Quanto menos o modelo tiver que adivinhar o que o usuário deseja, maior a probabilidade de obter o resultado esperado.1

Isso implica incluir detalhes relevantes na consulta para obter respostas mais pertinentes.1 Por exemplo, em vez de perguntar “Como somar números no Excel?”, um prompt mais eficaz seria “Como somar uma linha de valores monetários no Excel? Quero fazer isso automaticamente para uma planilha inteira de linhas, com todos os totais aparecendo à direita em uma coluna chamada ‘Total’.”.1 A especificidade deve abranger o contexto desejado, o resultado esperado, o comprimento, o formato e o estilo da resposta.3 Reduzir descrições “fofas” ou imprecisas é crucial; a linguagem deve ser direta e concisa.3

A precisão na formulação da tarefa é vital. Se as saídas forem muito longas, deve-se solicitar respostas breves. Se forem muito simples, pode-se pedir uma redação de nível especializado.1 Essa abordagem de detalhamento minucioso assegura que o LLM compreenda plenamente os parâmetros da solicitação, minimizando a necessidade de inferências que podem levar a desvios do resultado desejado. A ausência dessa clareza pode forçar o modelo a fazer suposições, resultando em saídas que não se alinham com a intenção original do usuário.

B. Fornecimento de Contexto Abrangente e Metas Claras

Além de instruções claras, fornecer ao LLM todo o contexto necessário é fundamental. Isso inclui informações de fundo, textos de referência ou o objetivo geral da tarefa.1 Os LLMs podem inventar respostas falsas com confiança, especialmente sobre tópicos esotéricos ou ao solicitar citações e URLs.1 Assim como um gabarito ajuda um estudante, fornecer texto de referência aos modelos ajuda a responder com menos fabricações.1

Descrever por que se está tentando realizar uma tarefa pode ajudar o LLM a fornecer uma resposta mais útil.5 Por exemplo, dizer que se deseja “configurar um site Google Cloud simples e seguro para hospedar um blog” oferece mais detalhes úteis do que apenas perguntar “como implantar um site”.5 O framework CO-STAR, recomendado pela Alibaba Cloud para seus modelos Qwen, encapsula bem essa necessidade, sugerindo que um prompt ideal deve incluir Contexto, Objetivo, Estilo, Tom, Audiência e o formato da Resposta (Response).6

A importância de fornecer contexto reside no fato de que os LLMs, embora vastos em seu conhecimento treinado, não possuem informações específicas do domínio do usuário ou dados atualizados para além de seu corte de treinamento. Ao fornecer explicitamente esse contexto, o usuário “aterra” a resposta do LLM na realidade relevante para a tarefa. Sem esse contexto, o modelo pode recorrer a informações genéricas ou, pior, gerar informações plausíveis, mas incorretas (alucinações). A clareza das metas, por sua vez, direciona o modelo para o resultado específico desejado, evitando que ele explore tangentes irrelevantes, mesmo que contextualmente plausíveis. A combinação de contexto rico e metas bem definidas estreita significativamente o espaço de possíveis respostas, aumentando a probabilidade de uma saída útil e precisa.

C. Estruturação Inteligente do Prompt: Delimitadores, Posição da Instrução e Atribuição de Papéis

A forma como um prompt é estruturado pode impactar significativamente sua eficácia. O uso de delimitadores como ###, """, ou tags XML (por exemplo, <exemplo>, <contexto>) para indicar claramente partes distintas da entrada é uma prática recomendada por múltiplos desenvolvedores de LLMs.1 Esses delimitadores ajudam o modelo a distinguir entre instruções, contexto, exemplos e a consulta do usuário, facilitando uma análise mais precisa do prompt.

A posição da instrução também é um fator a ser considerado. Geralmente, colocar as instruções no início do prompt é o mais indicado.3 No entanto, uma nuance importante surge ao lidar com contextos muito longos. A Anthropic, por exemplo, sugere que, para documentos extensos, as instruções devem ser colocadas após o documento longo.9 Essa orientação divergente provavelmente se deve à forma como os mecanismos de atenção dos LLMs processam sequências longas; instruções no final podem ter um “efeito de recência” mais forte, garantindo que não sejam “esquecidas” ou diluídas pelo extenso contexto precedente. Isso sugere que a estrutura ótima do prompt pode precisar ser adaptada dinamicamente com base no comprimento do contexto e na arquitetura específica do modelo.

Atribuir um papel ao LLM (por exemplo, “Você é um assistente prestativo”, “Aja como um programador Python especialista”) é outra técnica estrutural poderosa.1 Isso guia o tom, o estilo, o nível de especialização e o comportamento geral do modelo. Mensagens de sistema podem ser usadas para definir instruções abrangentes ou personas persistentes.1 A estruturação eficaz do prompt, portanto, não se refere apenas ao conteúdo das instruções, mas à sua apresentação e segmentação, funcionando como uma camada de metacomunicação que direciona os mecanismos de análise e atenção do LLM.

D. Guiando com Exemplos: Da Proeza Zero-Shot à Few-Shot

Fornecer exemplos de pares de entrada-saída desejados (prompting few-shot) é uma maneira altamente eficaz de guiar o comportamento do LLM, melhorar a precisão e garantir a consistência da saída, especialmente para tarefas que exigem formatos ou estilos específicos.1

O prompting Zero-Shot ocorre quando o LLM recebe uma instrução sem nenhum exemplo.3 Funciona bem para tarefas simples ou aquelas com as quais o LLM já está altamente familiarizado. Em contraste, o prompting Few-Shot fornece ao LLM um pequeno número (tipicamente 1-5) de exemplos (“shots”) que demonstram a entrada e a saída desejadas.1 Esta abordagem é particularmente eficaz para:

- Impor formatos de saída específicos.3

- Guiar o estilo e o tom.7

- Melhorar a precisão em tarefas complexas ou com nuances.7

A elaboração de exemplos eficazes é crucial: eles devem ser relevantes para a tarefa, diversos (cobrindo casos extremos) e claramente estruturados (por exemplo, usando tags <exemplo> como recomendado pela Anthropic 7). A consistência na formatação dos exemplos também é fundamental.14 A OpenAI sugere começar com zero-shot, depois tentar few-shot e, se nenhum funcionar, considerar o fine-tuning.3 O Google Gemini recomenda incluir sempre exemplos few-shot.14

O prompting few-shot funciona como uma forma de “aprendizado no contexto”, onde o LLM adapta seu comportamento com base nos exemplos fornecidos, sem atualizar seus pesos subjacentes. Os exemplos efetivamente “ajustam” o modelo para a tarefa específica em questão, dentro do escopo daquela interação única. A qualidade desse “ajuste no contexto” depende fortemente da qualidade e relevância dos exemplos. A transição de zero-shot para few-shot, e potencialmente para fine-tuning 3, representa um espectro de adaptação do LLM a uma tarefa, sendo o few-shot um meio-termo custo-efetivo. A seleção dos exemplos few-shot ótimos é, em si, uma tarefa complexa, sugerindo um futuro onde os LLMs possam auxiliar na geração ou seleção dos exemplos mais eficazes.

E. O Ciclo Iterativo: Teste Sistemático, Avaliação e Refinamento

A engenharia de prompts é uma ciência empírica. Alcançar resultados ótimos requer uma abordagem sistemática para testar mudanças, avaliar saídas em relação a critérios claros e refinar iterativamente os prompts.1

Recomenda-se começar com prompts simples e adicionar gradualmente complexidade, contexto e exemplos.4 Mudanças incrementais devem ser feitas, e seu impacto no desempenho deve ser medido.1 É crucial definir critérios de sucesso claros – métricas ou rubricas qualitativas – para avaliar a qualidade das saídas do LLM.7 O desenvolvimento de um conjunto diversificado de casos de teste, representativos do uso no mundo real, é essencial para garantir poder estatístico nas avaliações.1 A engenharia de prompts é um processo iterativo; espere testar e revisar os prompts várias vezes, usando a saída do modelo para informar e melhorar os prompts futuros.12

A natureza iterativa da engenharia de prompts implica que não se trata apenas de criar um único prompt “perfeito”, mas de desenvolver um processo para otimização de prompts. Esse processo envolve a geração de hipóteses (como uma mudança no prompt pode melhorar a saída), experimentação (testar a mudança) e análise (avaliar o resultado). Essa abordagem científica 13 é fundamental para ir além de sucessos anedóticos. A necessidade de testes e avaliações sistemáticas, especialmente com muitos casos de teste para poder estatístico 1, aponta para a crescente importância de ferramentas automatizadas de avaliação e otimização de prompts. À medida que a complexidade do prompt aumenta, a iteração manual se torna menos viável, tornando cruciais técnicas como Engenheiro de Prompt Automático (APE) 20 e Otimização por Prompting (OPRO).22

Tabela 1: Princípios Fundamentais de Prompting – Resumo

| Princípio | Ideia Central | Benefício Chave | Referência de Snippet / Conceito de Exemplo |

| Clareza, Especificidade e Detalhe | Fornecer instruções explícitas e inequívocas com todos os detalhes necessários. | Reduz as suposições do modelo, melhora a precisão. | 1 (Incluir detalhes)3 (Ser específico)5 (Fornecer contexto) |

| Fornecimento de Contexto | Fornecer informações de base relevantes, metas ou textos de referência. | Fundamenta as respostas, aumenta a relevância e a factualidade. | 1 (Texto de referência)5 (Descrever o porquê)6 (Contexto CO-STAR) |

| Prompting Estruturado | Usar delimitadores, posicionamento estratégico de instruções e atribuir papéis. | Melhora a análise sintática, guia a atenção e a persona. | 1 (Delimitadores, Persona)3 (Instruções primeiro)7 (XML) |

| Instrução Guiada por Exemplo | Fornecer de 0 a poucos exemplos (zero-shot a few-shot) da entrada/saída desejada. | Impõe formato/estilo, melhora tarefas complexas. | 3 (Zero/Few-shot)7 (3-5 exemplos diversos)14 (Few-shot) |

| Refinamento Iterativo e Avaliação | Testar sistematicamente as mudanças, avaliar as saídas e refinar os prompts. | Permite melhoria e otimização contínuas. | 1 (Testar sistematicamente)13 (Iterar frequentemente)19 (Iterar) |

II. Um Guia Passo a Passo Meticuloso para a Criação de Prompts Superiores

Esta seção sintetizará os princípios fundamentais em um fluxo de trabalho prático e acionável que os usuários podem seguir para construir prompts de alta qualidade a partir do zero, visando resultados precisos e que potencialmente excedam as expectativas iniciais.

A. Passo 1: Definindo o Objetivo e Visualizando a Saída Ideal

Antes de redigir qualquer parte do prompt, o usuário deve ter uma compreensão absolutamente clara do que deseja que o LLM realize. Isso envolve:

- Definição da Tarefa: Qual é a tarefa específica? (por exemplo, resumo, geração de código, escrita criativa, análise de dados, resposta a perguntas).

- Articulação do Objetivo: Qual é o propósito final da saída do LLM? Como ela será utilizada?.5 Compreender o “porquê” ajuda a moldar o “o quê”.

- Visualização da Saída: Mentalmente (ou mesmo elaborando um exemplo), imagine a resposta perfeita. Quais são suas características principais? (por exemplo, comprimento, estilo, tom, formato, nível de detalhe). Essa saída desejada então se torna o alvo para o prompt.1

Este passo inicial é fundamentalmente sobre engenharia de requisitos para um agente de IA. Ao definir o objetivo e a saída ideal, o usuário está estabelecendo os critérios de sucesso pelos quais o desempenho do LLM será julgado.12 Essa clareza é vital para o subsequente processo de refinamento iterativo. O ato de visualizar a saída ideal pode, por si só, revelar complexidades ou ambiguidades na solicitação inicial, ajudando o prompter a identificar lacunas em sua própria compreensão da tarefa ou descobrir suposições implícitas que precisam ser explicitadas para o LLM.

B. Passo 2: Fornecendo Contexto Abrangente e Restrições

Com base no objetivo definido, forneça todas as informações de base necessárias, materiais de referência e restrições.

- Informações Relevantes: Inclua quaisquer dados, fatos ou conhecimento prévio que o LLM necessite.1

- Textos de Referência: Se fontes específicas devem ser usadas ou citadas, forneça-as diretamente no prompt ou por meios acessíveis.1

- Restrições: Declare claramente quaisquer limitações ou regras que o LLM deve seguir. Isso inclui o que o LLM não deve fazer (embora o enquadramento positivo seja muitas vezes melhor, veja o Passo 6).3 Exemplos: “Responda usando apenas o texto fornecido”, “O resumo deve ter menos de 200 palavras”, “Evite jargão técnico”.

- Consideração da Audiência: Defina o público-alvo para a saída, pois isso influencia o estilo, o tom e a complexidade.5

Contexto e restrições trabalham juntos para estreitar o “espaço de busca” do LLM por uma resposta válida. O contexto fornece o domínio de conhecimento relevante, enquanto as restrições definem os limites das saídas aceitáveis.14 A maneira como as restrições são formuladas pode impactar significativamente a conformidade do LLM. Restrições “rígidas” (por exemplo, “A saída DEVE ser um objeto JSON com as chaves ‘A’, ‘B’, ‘C'”) são frequentemente mais eficazes quando combinadas com exemplos (few-shot) que demonstram a restrição em ação.

C. Passo 3: Atribuindo uma Persona (Role-Playing)

Instrua o LLM a adotar uma persona ou papel específico. Isso ajuda a moldar o tom, estilo, vocabulário e nível de especialização da saída.

- Exemplos: “Aja como um analista financeiro especialista”, “Você é um blogueiro de viagens espirituoso e envolvente”, “Responda como se fosse um estudioso de Shakespeare”.1

- Prompts de Sistema: Para alguns modelos (como API da OpenAI, Claude), um prompt de nível de sistema pode ser usado para definir uma persona persistente durante uma conversa.1

A atribuição de persona provavelmente funciona enviesando a seleção de tokens do LLM para padrões de linguagem e conhecimento associados a essa persona em seus dados de treinamento.1 A eficácia de uma persona pode depender de quão bem representada essa persona está nos dados de treinamento do LLM. Personas muito nichadas ou obscuras podem não ser emuladas com tanta eficácia. Além disso, instruções de persona complexas podem ser desafiadoras para o LLM manter consistentemente, potencialmente levando a um “desvio de persona”.

D. Passo 4: Arquitetando o Prompt com Estrutura Lógica

Organize todos os elementos (instruções, contexto, exemplos, consulta, persona) em um prompt coerente e com fluxo lógico.

- Posicionamento da Instrução: Normalmente no início 3, mas considere o final para contextos muito longos.9

- Delimitadores: Use delimitadores (

###,""", tags XML) para separar seções claramente.1 - Fluxo Lógico: Garanta que o prompt seja lido logicamente. Se fornecer exemplos, eles devem normalmente vir após a instrução principal e o contexto, mas antes da consulta real.

- Estrutura Recomendada pelo Google: Papel, Contexto, Instrução, Formato de Saída.19

O ato de estruturar um prompt força o engenheiro de prompt a pensar mais claramente sobre os diferentes componentes de sua solicitação e suas relações. Essa estrutura atua como um “andaime” para o processo de raciocínio do LLM.8 Embora existam diretrizes estruturais gerais, a estrutura ótima pode variar sutilmente dependendo da arquitetura do LLM e da tarefa específica.

E. Passo 5: Integrando Exemplos de Alta Qualidade (Aprendizado Few-Shot)

Se a tarefa for complexa, exigir um formato específico ou se beneficiar de uma compreensão com nuances, forneça alguns exemplos de alta qualidade (prompting few-shot).

- Número de Exemplos: Tipicamente, 1-5 exemplos são eficazes.7

- Qualidade dos Exemplos: Devem ser relevantes, precisos, diversos (cobrindo casos extremos) e consistentes no formato e estilo desejados.7

- Posicionamento: Geralmente após a instrução principal e o contexto, claramente demarcados.7

A seleção e elaboração de exemplos few-shot é uma habilidade crítica. Exemplos ruins podem ser prejudiciais.7 Os exemplos atuam como uma forma poderosa e imediata de “fine-tuning no contexto”. À medida que as tarefas se tornam mais complexas, identificar os exemplos few-shot mais impactantes torna-se um desafio, apontando para o potencial de técnicas que ajudam a selecionar ou mesmo gerar exemplos ótimos.24

F. Passo 6: Enquadramento Positivo da Instrução (“Faça Isso” vs. “Não Faça Aquilo”)

Sempre que possível, diga ao LLM o que ele deve fazer, em vez do que ele não deve fazer. O enquadramento positivo é geralmente mais eficaz e menos propenso a interpretações errôneas.3

- Exemplo 3:

- Menos eficaz: “NÃO PEÇA NOME DE USUÁRIO OU SENHA.”

- Melhor: “O agente tentará diagnosticar o problema… abstendo-se de fazer perguntas relacionadas a PII. Em vez de pedir PII… encaminhe o usuário para o artigo de ajuda…”

Instruções negativas exigem que o LLM compreenda a negação e encontre um comportamento alternativo. Instruções positivas especificam diretamente o comportamento desejado, simplificando a tarefa do LLM. Embora o enquadramento positivo seja uma boa heurística, pode haver cenários complexos onde declarar explicitamente uma restrição negativa seja necessário, especialmente se o comportamento “indesejado” for um padrão muito comum para o LLM. Nesses casos, a restrição negativa pode precisar ser pareada com uma forte orientação positiva.

G. Passo 7: Habilitando Raciocínio Complexo – Decomposição e Estratégias de “Pensamento”

Para tarefas que exigem raciocínio complexo, cálculo ou processos de várias etapas, instrua explicitamente o LLM a decompor o problema ou “pensar” em sua solução.

- Especificar Etapas: “Especifique as etapas necessárias para concluir uma tarefa”.1

- Cadeia de Pensamento (CoT) / Pensamento Passo a Passo: Instrua o modelo a “pensar passo a passo” ou “elaborar sua própria solução antes de chegar a uma conclusão”.1

- Monólogo Interno / Scratchpad: Use técnicas onde o modelo pode mostrar seu trabalho ou processo de raciocínio, mesmo que oculto do usuário final.1 A Anthropic usa tags

<thinking>ou um “scratchpad”.10 - Dividir Tarefas Complexas: Decomponha uma tarefa complexa em subtarefas mais simples ou uma sequência de consultas.1 Isso também é conhecido como encadeamento de prompts (prompt chaining).13

Essas estratégias de “pensamento” funcionam forçando o LLM a alocar mais etapas computacionais (efetivamente, mais “pensamento”) ao problema antes de gerar uma resposta final. Cada etapa de raciocínio intermediário fornece contexto para as etapas subsequentes. O ato de gerar uma cadeia de pensamento não apenas melhora a precisão da resposta, mas também fornece uma visão valiosa do processo de “raciocínio” do LLM, que pode ser usado para depurar prompts ou entender as limitações do modelo.

H. Passo 8: Refinamento Iterativo – Analisando Saídas e Otimizando Entradas

A engenharia de prompts raramente é um sucesso de primeira. Após elaborar e executar um prompt inicial, analise cuidadosamente a saída do LLM em relação aos objetivos definidos no Passo 1.

- Avaliação: A saída é precisa? Está no formato correto? Tem o tom e estilo certos? Atende a todas as restrições?.1

- Identificar Discrepâncias: Onde a saída falha?

- Hipotetizar Melhorias: Com base nas discrepâncias, formule hipóteses sobre como modificar o prompt.

- Modificar e Retestar: Faça alterações direcionadas ao prompt e execute novamente os casos de teste.1

- Abordagem Sistemática: Altere um elemento de cada vez, se possível, para isolar o impacto de cada modificação.

Este passo fecha o “loop de feedback” na engenharia de prompts. A saída do LLM serve como dados que informam a próxima iteração do design do prompt.18 À medida que os prompts se tornam mais complexos, o processo de refinamento iterativo em si se torna mais desafiador, apontando para a necessidade de ferramentas e metodologias de “depuração de prompts”.

III. Dominando Técnicas Avançadas de Engenharia de Prompts

Esta seção explora técnicas sofisticadas que transcendem a construção básica de prompts, permitindo aos usuários desbloquear níveis mais elevados de raciocínio, precisão e capacidades especializadas dos LLMs.

A. Aprimorando o Raciocínio: Cadeia de Pensamento (CoT) e Suas Evoluções

A Cadeia de Pensamento (CoT) guia o LLM a gerar uma série de etapas de raciocínio intermediárias antes de chegar a uma resposta final, melhorando significativamente o desempenho em tarefas que exigem raciocínio aritmético, de senso comum e simbólico.1

- 1. Cadeia de Pensamento Padrão (CoT): Envolve solicitar ao modelo que “pense passo a passo” ou fornecer exemplos few-shot que incluem etapas de raciocínio explícitas.1 Isso força o LLM a decompor problemas complexos, onde cada pensamento se baseia no anterior, melhorando a precisão ao tornar o processo de raciocínio explícito.25

- 2. CoT Zero-Shot: Consegue-se simplesmente anexando uma frase como “Vamos pensar passo a passo” à pergunta, sem fornecer exemplos few-shot explícitos de cadeias de raciocínio.25 É mais simples de implementar, pois não requer a elaboração de exemplos detalhados.

- 3. CoT Few-Shot: Fornecer exemplos que incluem a pergunta, as etapas de raciocínio intermediárias e a resposta final.13 Muitas vezes é mais eficaz do que o CoT Zero-Shot para tarefas muito complexas ou novas.

- 4. Cadeia de Pensamento Automática (Auto-CoT): Automatiza a geração de demonstrações de CoT. Agrupa perguntas e depois usa CoT Zero-Shot para gerar cadeias de raciocínio para perguntas representativas de cada grupo.22 Isso dimensiona o prompting CoT, reduzindo o esforço manual de criação de exemplos.32

- 5. Cadeia de Pensamento Lógica (LogiCoT / Lógica do Pensamento LoT): Aprimora o CoT incorporando princípios da lógica simbólica para verificar etapas de raciocínio (LogiCoT) 22 ou extraindo, estendendo com regras formais e traduzindo proposições lógicas de volta para linguagem natural para aumentar o prompt (Lógica do Pensamento).22 Isso visa tornar as etapas de raciocínio mais robustas e menos propensas a conclusões “infiéis”.34

- 6. Cadeia de Pensamento Tabular (Tab-CoT): Estrutura o processo de raciocínio CoT em um formato tabular (por exemplo, tabela Markdown com colunas como Etapa, Subpergunta, Processo, Resultado).22 A tabela incentiva o raciocínio organizado e bidimensional.36

- 7. Cadeia de Pensamento Contrastiva (CCoT / CD-CoT): CCoT emprega exemplos de raciocínio negativos (incorretos) juntamente com positivos (corretos) para ajudar o modelo a aprender quais erros evitar.22 CD-CoT (Cadeia de Pensamento com Denoising Contrastivo) aborda especificamente racionais ruidosos em exemplos, contrastando-os com um racional limpo.22

- 8. Cadeia de Pensamento Reversa (R-CoT): Visa detectar e retificar alucinações de condição, reconstruindo o problema a partir da solução CoT inicial (potencialmente falha) do LLM, comparando-o com o problema original para identificar discrepâncias e, em seguida, fornecendo esse feedback detalhado ao LLM para revisão.22

- 9. Cadeia de Pensamento Auto-Harmonizada (ECHO): Refina múltiplos caminhos de raciocínio diversos (gerados talvez por Auto-CoT) em um padrão de raciocínio unificado e consistente por meio de um processo iterativo de auto-harmonização.22

- 10. Cadeia de Pensamento Estruturada (SCoT): Incorpora estruturas semelhantes a programas (sequência, ramificação, loop) em etapas de raciocínio, particularmente para gerar código-fonte estruturado ou planos complexos.22

A evolução do CoT básico para versões mais automatizadas, estruturadas, infundidas de lógica e com correção de erros indica uma tendência para tornar o processo de “pensamento” mais robusto, verificável e eficiente. A proliferação de variantes de CoT sugere que o “raciocínio” em LLMs não é uma capacidade monolítica, mas uma interação complexa de correspondência de padrões, geração sequencial e (quando solicitado corretamente) dedução lógica simulada.

B. Estratégias de Autoaperfeiçoamento: Autoconsistência, Auto-Refinamento, Cadeia de Verificação (CoVe)

Essas técnicas capacitam os LLMs a melhorar suas próprias saídas, gerando múltiplas soluções, criticando seu trabalho ou verificando fatos, levando a respostas finais mais robustas e precisas.

- 1. Autoconsistência (Self-Consistency): Em vez de apenas seguir o primeiro caminho de raciocínio de um prompt CoT, gera múltiplos caminhos de raciocínio diversos (por exemplo, aumentando a temperatura) e, em seguida, seleciona a resposta final que aparece com mais frequência entre esses caminhos.22 Isso aproveita a ideia de que existem várias maneiras de raciocinar para uma resposta correta.25

- 2. Auto-Refinamento (Self-Refine): Um processo iterativo onde o LLM primeiro gera uma saída inicial, depois fornece feedback sobre sua própria saída e, finalmente, refina a saída com base nesse feedback. Este ciclo pode se repetir.22 Imita a melhoria iterativa humana, com o LLM atuando como seu próprio crítico e revisor.45

- 3. Cadeia de Verificação (CoVe): Visa reduzir alucinações fazendo com que o LLM primeiro gere uma resposta base, depois planeje perguntas de verificação sobre sua própria resposta, responda a essas perguntas e, finalmente, gere uma resposta revisada e verificada.22 Força o LLM a verificar novamente suas próprias declarações e fatos antes de finalizar uma resposta.47

Essas técnicas de autoaperfeiçoamento aproveitam as capacidades generativas do LLM tanto para criação quanto para avaliação. A Autoconsistência explora o espaço de solução de forma mais ampla, enquanto o Auto-Refinamento e o CoVe introduzem um loop explícito de “pensamento crítico”. Isso demonstra que diferentes “modos” de operação podem ser eliciados do mesmo modelo por meio de prompts. No entanto, a eficácia dessas técnicas ainda depende da capacidade inerente do LLM de gerar bom feedback ou caminhos diversos.47

C. Navegando na Complexidade com Pensamento Hierárquico e Baseado em Grafos (ToT, GoT, LoT, EEDP)

Para problemas altamente complexos que exigem a exploração de múltiplas linhas de raciocínio, retrocesso ou consideração de relações intrincadas, técnicas que estruturam os “pensamentos” do LLM como árvores ou grafos oferecem capacidades de raciocínio mais poderosas do que o CoT linear.

- 1. Árvore de Pensamentos (ToT – Tree-of-Thoughts): Permite que os LLMs explorem múltiplos caminhos de raciocínio em paralelo, como galhos de uma árvore. O modelo pode gerar múltiplos “pensamentos” (próximos passos potenciais), avaliá-los e decidir qual caminho seguir, incluindo retroceder se um caminho parecer pouco promissor.22 Utiliza “prompts de proposta” para gerar candidatos a pensamentos e “prompts de valor” para avaliá-los.50

- 2. Grafo de Pensamentos (GoT – Graph-of-Thoughts): Generaliza o ToT, permitindo que os pensamentos formem uma estrutura de grafo arbitrária, onde os pensamentos são vértices e as dependências são arestas. Isso permite interações mais complexas, como agregar pensamentos de diferentes ramos ou criar loops de feedback.22 Envolve transformações como agregação, refinamento e geração.53

- 3. Camada de Pensamentos (LoT – Layer-of-Thoughts): Estende o GoT particionando os pensamentos em camadas (pensamentos de camada para etapas conceituais, pensamentos de opção para encontrar soluções) e utiliza hierarquias de restrição para filtrar e refinar respostas candidatas, particularmente para tarefas de recuperação.22

- 4. Prompting de Caminho DAG de Ponta a Ponta (EEDP – End-to-End DAG-Path): Uma técnica de achatamento de grafos para LLMs melhorarem o raciocínio em dados estruturados em grafos, especialmente para dependências de longo alcance. Converte grafos em texto focado em caminhos principais chave entre pontos finais, usando uma representação de Grafo Acíclico Direcionado (DAG).22

Essas técnicas representam um passo significativo para permitir que os LLMs realizem um pensamento mais “deliberativo” ou de “Sistema 2” 60, em vez de apenas uma conclusão de padrão rápida e intuitiva de “Sistema 1”. Os principais desafios são o custo computacional e a complexidade de projetar prompts eficazes de proposta, avaliação e transformação.

D. Controle Avançado de Contexto e Atenção (Atenção Sistema 2, Fio do Pensamento, Buffer de Pensamentos)

Essas técnicas visam melhorar como os LLMs lidam e atentam para informações dentro de sua janela de contexto, especialmente ao lidar com contextos ruidosos, irrelevantes ou muito longos.

- 1. Atenção Sistema 2 (S2A – System 2 Attention): Solicita ao LLM que primeiro regenere o prompt original para incluir apenas informações relevantes, filtrando efetivamente o contexto irrelevante antes de responder à consulta principal.22 Inspirado no pensamento de Sistema 1 (rápido) vs. Sistema 2 (lento, deliberado) de Kahneman.60

- 2. Fio do Pensamento (ThoT – Thread of Thought): Projetado para “contextos caóticos” (grandes volumes de texto com relevância variável). Segmenta e analisa metodicamente contextos estendidos, com o LLM resumindo e analisando cada parte progressivamente para extrair detalhes relevantes para uma consulta específica.22

- 3. Buffer de Pensamentos (BoT – Buffer of Thoughts): Visa melhorar a eficiência e robustez do raciocínio usando um “meta-buffer” de “modelos de pensamento” de alto nível destilados de processos anteriores de resolução de problemas. Quando um novo problema chega, ele é simplificado, elementos-chave são extraídos e um modelo de pensamento relevante é recuperado e instanciado para guiar a solução.22

S2A, ThoT e BoT abordam o desafio de que os LLMs, apesar das grandes janelas de contexto, não “atentam” automaticamente para as informações de maneira ideal. Essas técnicas essencialmente “estruturam” os estágios de atenção e processamento de informações para o LLM. O desenvolvimento dessas técnicas de gerenciamento de contexto/atenção sugere um movimento em direção a um “descarregamento cognitivo” mais explícito no design de prompts, onde partes do processo de raciocínio ou filtragem de informações são explicitamente divididas e tratadas por componentes de prompt dedicados ou mesmo chamadas separadas de LLM.

E. Paradigmas de Prompting Especializados

Uma gama diversificada de técnicas projetadas para tipos específicos de tarefas ou para eliciar comportamentos particulares do LLM.

- 1. ReAct (Raciocinar e Agir): Permite que os LLMs gerem tanto rastros de raciocínio quanto ações específicas da tarefa de maneira intercalada. As ações permitem que o LLM interaja com ferramentas externas (por exemplo, mecanismos de busca, APIs) para coletar informações ou realizar operações, e então incorpore os resultados de volta em seu processo de raciocínio.22 Essencial para construir agentes.

- 2. Geração Aumentada por Recuperação (RAG – Retrieval Augmented Generation): Combina um sistema de recuperação (que busca trechos de documentos relevantes de uma base de conhecimento com base na consulta) com um gerador LLM (que usa esses trechos como contexto para sintetizar uma resposta).22 Reduz alucinações e permite o uso de informações atualizadas ou proprietárias.

- 3. Prompting Emocional (EmotionPrompting / Emotion Prompt): Anexar frases que transmitem contexto emocional ou importância (por exemplo, “Isso é muito importante para minha carreira.”) a um prompt para potencialmente melhorar o desempenho, a veracidade e a responsabilidade percebida do LLM.22 Pode levar a um melhor desempenho, possivelmente aumentando o “esforço” ou “cuidado” do modelo ao gerar uma resposta.70

- 4. SimToM (Teoria da Mente Simulada): Uma técnica de prompting de duas etapas que incentiva um modelo a considerar uma perspectiva específica. Primeiro, identifica e isola informações relevantes para uma entidade; segundo, pede ao modelo para responder à consulta da perspectiva dessa entidade, com base apenas nesses fatos.35 Útil para questões complexas com múltiplas entidades.

- 5. Refrasear e Responder (RaR – Rephrase and Respond): Pede ao LLM para primeiro refrasear e expandir uma pergunta antes de respondê-la. Isso pode ajudar a refinar consultas ambíguas para respostas melhores, especialmente para prompts mais curtos e vagos.22

- 6. Releitura (RE2 – Re-reading): Melhora o desempenho do LLM solicitando ao modelo que releia a pergunta antes de responder, reduzindo erros por detalhes perdidos. É versátil e pode ser aplicada a tarefas de raciocínio aritmético, de senso comum e simbólico.35

- 7. Prompting de Passo Atrás (Step-Back Prompting): Melhora a capacidade de raciocínio dos LLMs, incentivando-os a “dar um passo atrás” e focar em princípios abstratos antes de raciocinar sobre detalhes. O modelo primeiro deriva conceitos de alto nível e princípios fundamentais antes de abordar detalhes específicos.35

- 8. Prompting Analógico (Analogical Prompting): Aprimora o processo de raciocínio dos LLMs inspirando-se no raciocínio analógico humano. Incentiva os LLMs a autogerar exemplos relevantes antes de abordar novos problemas.35

- 9. Cadeia de Símbolos (CoS – Chain-of-Symbol): Representa relações espaciais com símbolos condensados durante as etapas de pensamento intermediário encadeadas, superando o CoT em tarefas de planejamento espacial com menos tokens.22

- 10. Cadeia de Rascunho (CoD – Chain of Draft): Um paradigma onde os LLMs geram saídas de raciocínio intermediárias minimalistas, porém informativas, ao resolver tarefas, priorizando eficiência e minimalismo em vez de etapas intermediárias verbosas.22

- 11. Cadeia de Notas (CoN – Chain-of-Note): Aprimora a robustez do prompt em face de documentos ruidosos ou irrelevantes e cenários desconhecidos, gerando notas de leitura sequenciais para documentos recuperados, facilitando uma avaliação abrangente de sua relevância e integrando essas informações para formular a resposta final.22

- 12. Cadeia de Conhecimento (CoK – Chain-of-Knowledge): Aborda limitações em técnicas de prompting existentes, particularmente problemas de alucinação no CoT. Implementa uma abordagem estruturada para representação e verificação do conhecimento por meio de triplas de evidência e dicas de explicação.22

- 13. Prompting Ativo (Active Prompting): Melhora o desempenho do prompting CoT, anotando seletivamente exemplos humanos onde o modelo mostra mais incerteza, maximizando a eficiência dos esforços de anotação humana.22

- 14. Engenheiro de Prompt Automático (APE – Automatic Prompt Engineer): Automatiza o processo de geração e refinamento de prompts para um LLM para melhorar o desempenho do modelo em uma tarefa específica, usando a ideia de engenharia de prompt e automatizando todo o processo.20

- 15. Raciocínio e Uso de Ferramentas Automático (ART – Automatic Reasoning and Tool-use): Um framework que usa LLMs congelados para gerar automaticamente etapas de raciocínio intermediárias como um programa. Dada uma nova tarefa, ART seleciona demonstrações de raciocínio de várias etapas e uso de ferramentas de uma biblioteca de tarefas e integra perfeitamente a saída de ferramentas externas.22

- 16. Programa de Pensamentos (PoT – Program of Thoughts): Aprimora o desempenho em tarefas de raciocínio numérico, separando as etapas de raciocínio da computação final. O LLM gera etapas de raciocínio como declarações de linguagem de programação, que são então executadas por um intérprete externo como Python.22

- 17. Cadeia de Código (CoC – Chain-of-Code): Combina os pontos fortes da execução de código e do raciocínio baseado em linguagem, fazendo com que o modelo gere uma mistura de código executável e “placeholders semânticos”. Um “LMulator” simula partes não executáveis.22

- 18. Otimização por Prompting (OPRO – Optimization by Prompting): Usa LLMs como otimizadores, usando prompts em linguagem natural para gerar iterativamente soluções com base na descrição do problema e em soluções descobertas anteriormente.20

- 19. Prompting Adaptativo à Instância (IAP – Instance-adaptive Prompting): Melhora o raciocínio em LLMs, adaptando os prompts a perguntas individuais com base em pontuações de saliência que analisam o fluxo de informações entre a pergunta, o prompt e o racional.22

A eficácia dessas técnicas especializadas geralmente depende da natureza específica da tarefa e do LLM utilizado. A experimentação e a adaptação são fundamentais. A tendência geral é para prompts mais interativos, modulares e autoadaptáveis, onde o LLM desempenha um papel mais ativo na formulação e execução da estratégia de resolução de problemas.

IV. Conclusões e Recomendações Futuras

A engenharia de prompts é uma disciplina dinâmica e essencial para maximizar a utilidade dos Modelos de Linguagem Grandes. A pesquisa e a prática demonstraram consistentemente que a forma como uma instrução é formulada e contextualizada tem um impacto direto e significativo na qualidade, precisão e relevância da saída do LLM.

As técnicas fundamentais – clareza, especificidade, fornecimento de contexto, estruturação lógica e orientação por exemplos – formam a base indispensável para qualquer interação bem-sucedida com LLMs. A negligência desses princípios invariavelmente leva a resultados subótimos, independentemente da sofisticação do modelo. O processo de criação de prompts é inerentemente iterativo; raramente um prompt perfeito emerge na primeira tentativa. Portanto, uma abordagem científica, envolvendo testes sistemáticos, avaliação criteriosa e refinamento contínuo, é crucial.

As técnicas avançadas, como as diversas evoluções da Cadeia de Pensamento (CoT), estratégias de autoaperfeiçoamento (Autoconsistência, Auto-Refinamento, CoVe) e métodos de raciocínio hierárquico ou baseado em grafos (ToT, GoT), representam avanços significativos na capacidade dos LLMs de lidar com problemas complexos. Essas técnicas, em essência, guiam os LLMs a emular estratégias de resolução de problemas mais sofisticadas e humanas, como decomposição de problemas, exploração de múltiplas soluções, avaliação crítica e síntese de informações.

O controle avançado de contexto e atenção, exemplificado por S2A, ThoT e BoT, aborda as limitações dos LLMs no processamento eficiente e focado de grandes volumes de informação ou dados ruidosos. Paradigmas especializados como ReAct, RAG e EmotionPrompting expandem ainda mais o leque de aplicações, permitindo que os LLMs interajam com o mundo externo, utilizem conhecimento específico e até respondam a nuances emocionais.

Implicações e Direções Futuras:

- Automatização e Meta-Prompting: A complexidade crescente da engenharia de prompts e a necessidade de otimização contínua apontam para uma maior automatização. Técnicas como APE e OPRO, onde LLMs otimizam prompts para outros LLMs, provavelmente se tornarão mais prevalentes. O papel do engenheiro de prompt humano pode evoluir para o design de meta-prompts e critérios de avaliação para esses sistemas de otimização.

- Adaptabilidade Dinâmica do Prompt: Em vez de prompts estáticos, o futuro pode ver LLMs que adaptam dinamicamente sua estratégia de prompting (por exemplo, escolhendo a variante CoT mais adequada ou o número de exemplos few-shot) com base nas características da consulta em tempo real, como sugerido por técnicas como IAP.

- Interpretabilidade e Depuração: À medida que os prompts se tornam mais complexos, envolvendo múltiplas técnicas encadeadas, a necessidade de ferramentas de interpretabilidade e depuração de prompts se tornará crítica. LLMs poderiam ser usados para analisar prompts e respostas, identificando possíveis falhas ou sugerindo melhorias.

- Modularidade e Composição: Prompts complexos podem ser construídos de forma mais robusta e gerenciável através de abordagens modulares, onde diferentes componentes do prompt (contexto, exemplos, restrições, sub-tarefas de raciocínio) são otimizados e combinados.

- Aprendizagem Contínua de Estratégias de Prompting: O conceito de “meta-buffer” em técnicas como BoT sugere que os LLMs poderiam aprender e reutilizar padrões abstratos de resolução de problemas ao longo do tempo, tornando-se aprendizes mais eficientes e adaptáveis na própria arte da engenharia de prompts.

Em suma, a engenharia de prompts está evoluindo de uma arte para uma ciência cada vez mais sofisticada. A maestria dessas técnicas é indispensável para qualquer indivíduo ou organização que busque aproveitar todo o potencial transformador dos Modelos de Linguagem Grandes. A pesquisa contínua e a experimentação prática continuarão a refinar nossa compreensão e a expandir o horizonte do que é possível alcançar através da interação estratégica com essas poderosas ferramentas de IA.

Fontes usadas na pesquisa:

platform.openai.com

Prompt engineering – OpenAI API – OpenAI Platform

Abre em uma nova janela

kaggle.com

Prompt Engineering | Kaggle

Abre em uma nova janela

help.openai.com

Best practices for prompt engineering with the OpenAI API | OpenAI …

Abre em uma nova janela

cloud.google.com

Write better prompts for Gemini for Google Cloud

Abre em uma nova janela

anthropic.com

Prompt engineering for business performance \ Anthropic

Abre em uma nova janela

ai.google.dev

Prompt design strategies | Gemini API | Google AI for Developers

Abre em uma nova janela

docs.anthropic.com

Use examples (multishot prompting) to guide Claude’s behavior – Anthropic API

Abre em uma nova janela

huggingface.co

@hesamation on Hugging Face: “Google published a 69-page whitepaper on Prompt Engineering and its best…”

Abre em uma nova janela

communeify.com

Google Drops a 69-Page Prompt Engineering Bible! The Secret to Unlocking AI’s Full Potential – Communeify

Abre em uma nova janela

prompthub.us

Using Anthropic: Best Practices, Parameters, and Large Context …

Abre em uma nova janela

anthropic.com

Prompt engineering for Claude’s long context window \ Anthropic

Abre em uma nova janela

bootstrapcreative.com

Google Prompt Engineering Whitepaper: Key Takeaways for …

Abre em uma nova janela

outshift.cisco.com

6 advanced AI prompt engineering techniques for better … – Outshift

Abre em uma nova janela

mercity.ai

Advanced Prompt Engineering Techniques – Mercity AI

Abre em uma nova janela

encora.com

LLM Prompt Engineering: Key Purpose & How To Effectively Use – Encora

Abre em uma nova janela

alibabacloud.com

Alibaba Cloud Model Studio:Best practices for prompt engineering

Abre em uma nova janela

inferless.com

Qwen Models: Alibaba’s Next-Generation AI Family for Text, Vision, and Beyond – Inferless

Abre em uma nova janela

arxiv.org

A Systematic Survey of Prompt Engineering in Large Language Models: Techniques and Applications – arXiv

Abre em uma nova janela

alignmentforum.org

Tips for Empirical Alignment Research – AI Alignment Forum

Abre em uma nova janela

cohere.com

Prompt Engineering for AI: Definition and Use Cases – Cohere

Abre em uma nova janela

alignmentforum.org

We should try to automate AI safety work asap – AI Alignment Forum

Abre em uma nova janela

learn.deeplearning.ai

ChatGPT Prompt Engineering for Developers – DeepLearning.AI – Learning Platform

Abre em uma nova janela

reddit.com

Need suggestions how to get deep into AI prompte and its creations – Reddit

Abre em uma nova janela

docs.cohere.com

A Guide to Crafting Effective Prompts – Cohere Documentation

Abre em uma nova janela

arxiv.org

The Prompt Report: A Systematic Survey of Prompt Engineering Techniques – arXiv

Abre em uma nova janela

arxiv.org

arxiv.org

Abre em uma nova janela

learnprompting.org

Self-Refine: Iterative Refinement with Self-Feedback for LLMs

Abre em uma nova janela

mirascope.com

Self-Refine: Enhancing LLM Outputs Through Iterative Self-Improvement – Mirascope

Abre em uma nova janela

ojs.aaai.org

ojs.aaai.org

Abre em uma nova janela

learnprompting.org

Tree of Thoughts (ToT): Enhancing Problem-Solving in LLMs

Abre em uma nova janela

towardsdatascience.com

Something-of-Thought in LLM Prompting: An Overview of Structured LLM Reasoning

Abre em uma nova janela

prompthub.us

How Tree of Thoughts Prompting Works – PromptHub

Abre em uma nova janela

k2view.com

AI Prompt Engineering: The Art of AI Instruction – K2view

Abre em uma nova janela

learnprompting.org

Thread of Thought (ThoT) – Learn Prompting

Abre em uma nova janela

relevanceai.com

Master Thread of Thought Prompting for Effective Conversations – Relevance AI

Abre em uma nova janela

prompthub.us

How to Use System 2 Attention Prompting to Improve LLM Accuracy

Abre em uma nova janela

learnprompting.org

System 2 Attention (S2A) Prompting: Filtering Irrelevant Context

Abre em uma nova janela

learnprompting.org

Add Depth to AI Responses with Emotional Language – Learn Prompting

Abre em uma nova janela

arxiv.org

A Systematic Survey of Prompt Engineering in Large Language Models: Techniques and Applications – arXiv

Abre em uma nova janela

prompthub.us

Getting Emotional With LLMs – PromptHub

Abre em uma nova janela

learnprompting.org

Tabular Chain-of-Thought (Tab-CoT) – Learn Prompting

Abre em uma nova janela

mirascope.com

Tabular Chain of Thought – Mirascope

Abre em uma nova janela

learnprompting.org

Analogical Prompting

Abre em uma nova janela

learnprompting.org

Analogical Prompting

Abre em uma nova janela

learnprompting.org

Step-Back Prompting

Abre em uma nova janela

prompthub.us

A Step Forward with Step-Back Prompting – PromptHub

Abre em uma nova janela

learnprompting.org

Re-reading (RE2) Prompting: Boosting LLM Accuracy with Simple Re-evaluation

Abre em uma nova janela

learnprompting.org

Rephrase and Respond (RaR) Prompting: Improving LLM Answers with Rephrasing

Abre em uma nova janela

lmtoolkit.com

Rereading (Re2) – The Language Model Toolkit

Abre em uma nova janela

mirascope.com

Rephrase and Respond – Mirascope

Abre em uma nova janela

relevanceai.com

Use SimToM for Better Prompting in AI Models

Abre em uma nova janela

python.useinstructor.com

SimToM (Simulated Theory of Mind) – Instructor

Abre em uma nova janela

prompthub.us

Using LLMs to Optimize Your Prompts – PromptHub

Abre em uma nova janela

learnprompting.org

Logic-of-Thought (LoT): Enhancing Logical Reasoning in Large Language Models

Abre em uma nova janela

aclanthology.org

LogiCoT: Logical Chain-of-Thought Instruction Tuning – ACL Anthology

Abre em uma nova janela

ibm.com

What is chain of thought (CoT) prompting? – IBM

Abre em uma nova janela

analyticsvidhya.com

What is Chain of Symbol in Prompt Engineering? – Analytics Vidhya

Abre em uma nova janela

learnprompting.org

Automatic Chain of Thought (Auto-CoT) – Learn Prompting

Abre em uma nova janela

relevanceai.com

Utilize Chain of Code for Effective Problem Solving – Relevance AI

Abre em uma nova janela

openreview.net

Chain-of-Symbol Prompting for Spatial Relationships in Large Language Models

Abre em uma nova janela

learnprompting.org

Chain of Code (CoC) – Learn Prompting

Abre em uma nova janela

relevanceai.com

Master Structured Chain-of-Thought Prompting for Better AI Results – Relevance AI

Abre em uma nova janela

prompthub.us

Program of Thoughts Prompting Guide – PromptHub

Abre em uma nova janela

blog.synapticlabs.ai

ART: Automatic Multi-step Reasoning and Tool-use for Large Language Models

Abre em uma nova janela

learnprompting.org

learnprompting.org

Abre em uma nova janela

flexos.work

Chain of Thought Prompting: Step-by-Step for Better Reasoning – FlexOS

Abre em uma nova janela

arxiv.org

ART: Automatic multi-step reasoning and tool-use for large language models – arXiv

Abre em uma nova janela

towardsdatascience.com

Automated Prompt Engineering: The Definitive Hands-On Guide | Towards Data Science

Abre em uma nova janela

relevanceai.com

Create Effective Chain-of-Knowledge Prompts for AI – Relevance AI

Abre em uma nova janela

portkey.ai

Automatic Prompt Engineering: Boosting AI Performance with Smarter Prompts – Portkey

Abre em uma nova janela

learnprompting.org

Active Prompting

Abre em uma nova janela

docs.anote.ai

Active Prompting – Anote

Abre em uma nova janela

learnprompting.org

Chain of Knowledge (CoK) – Learn Prompting

Abre em uma nova janela

relevanceai.com

Utilize Chain-of-Note and Chain-of-Thought Techniques for Better AI Interactions

Abre em uma nova janela

galileo.ai

RAG LLM Prompting Techniques to Reduce Hallucinations – Galileo AI

Abre em uma nova janela

arxiv.org

Chain of Draft: Thinking Faster by Writing Less – arXiv

Abre em uma nova janela

learnprompting.org

Reversing Chain-of-Thought (RCoT) Prompting: Enhancing LLM Accuracy with Fine-Grained Feedback

Abre em uma nova janela

analyticsvidhya.com

Chain of Draft Prompting with Gemini and Groq – Analytics Vidhya

Abre em uma nova janela

learnprompting.org

Chain-of-Verification (CoVe): Reduce LLM Hallucinations – Learn Prompting

Abre em uma nova janela

relevanceai.com

Implement Chain-of-Verification to Improve AI Accuracy – Relevance AI

Abre em uma nova janela

learnprompting.org

Contrastive Chain-of-Thought Prompting: Boosting AI Reasoning

Abre em uma nova janela

openreview.net

Can Language Models Perform Robust Reasoning in Chain-of-thought Prompting with Noisy Rationales? – OpenReview

Abre em uma nova janela

arxiv.org

[2410.12153] Layer-of-Thoughts Prompting (LoT): Leveraging LLM-Based Retrieval with Constraint Hierarchies – arXiv

Abre em uma nova janela

arxiv.org

arXiv:2410.12153v1 [cs.CL] 16 Oct 2024

Abre em uma nova janela

learnprompting.org

Self-Harmonized Chain-of-Thought (ECHO) – Learn Prompting

Abre em uma nova janela

learnprompting.org

Instance-adaptive Zero-Shot Chain-of-Thought Prompting (IAP)

Abre em uma nova janela

towardsdatascience.com

Understanding Buffer of Thoughts (BoT) – Reasoning with Large Language Models

Abre em uma nova janela

openreview.net

Buffer of Thoughts: Thought-Augmented Reasoning with Large Language Models

Abre em uma nova janela

proceedings.neurips.cc

Instance-adaptive Zero-shot Chain-of-Thought Prompting

Abre em uma nova janela

arxiv.org

arxiv.org

Abre em uma nova janela

arxiv.org

arxiv.org

Abre em uma nova janela

learnprompting.org

End-to-End DAG-Path (EEDP) Prompting – Learn Prompting

Abre em uma nova janela

api.semanticscholar.org

End-to-End Graph Flattening Method for Large Language Models – Semantic Scholar API

Abre em uma nova janela

learnprompting.org

GraphRAG – Learn Prompting